Transformer 架构彻底转变了自然言语处理,使 GPT 等模型能够高效地预测序列中的下一个 token。然而,这些模型存在一个根本性的局限性,即需要对所有之前的 token 进行一次性投影来预测下一个 token,这限制了它们的迭代改善才能。无论预测 token 的困难性或模糊性如何,Transformer 都会持续施加计算劳动,缺乏重新考虑或改善预测的机制。包括 Transformer 在内的习俗神经互联网在单次前向传递中将输入序列映射到预测结果,并通过多层处理输入以改善内部表征。

通用 Transformer 引入了 Transformer 层的循环应用,通过迭代细化表征来捕捉短期和长期依赖关系。然而,试验仅限于较小的模型和数字集,而非像 GPT-2 这样的大规模言语模型。自适应计算时光模型许可动态确定每个输入的计算步骤,但主要应用于容易的 RNN 架构,并在不使用 Transformer 架构或大规模预训练的情况下在小规模任务上进行测试。深度自适应 Transformer 根据输入调整互联网深度,通过挑选每个输入序列应用的层数来实现动态推理。然而,这些方法缺乏更高级架构中常见的预测残差设计。

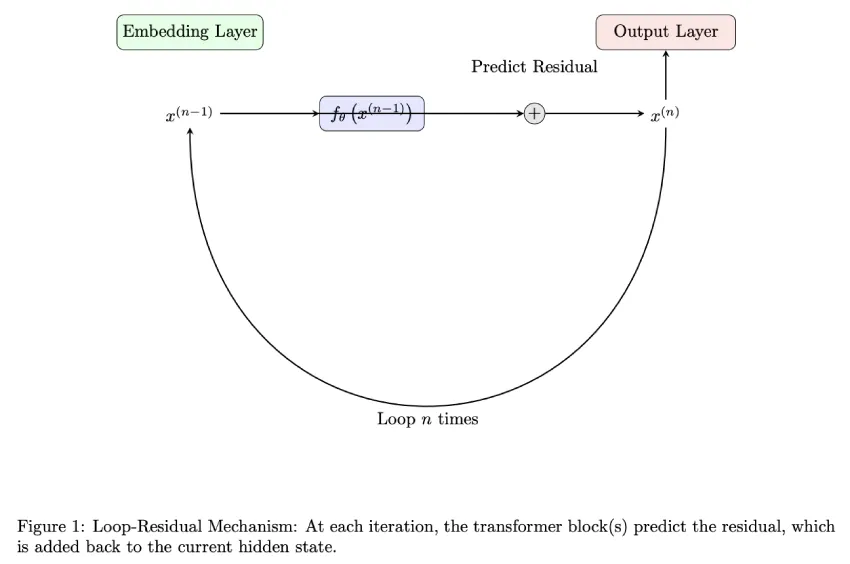

香港大学的研发人员提出了一种新颖的 Loop-Residual 神经互联网 (Loop-Residual Neural Network),该互联网会多次重访输入,并通过在模型子集上进行迭代循环来完善预测。它采用一种带有残差预测的新型循环架构,从而提升了 Transformer 的性能,并延长了推理时光。该方法无需额外的训练数字,即可有效应用于大型神经互联网,从而扩展了模型的逼近才能。通过将规范 GPT-2 版本与循环残差模型进行对比,试验证明了其有效性。值得注意的是,他们的 GPT-2-81M 模型在 OpenWebText 数字集上的验证亏损为 3.11,与 GPT-2-124M 模型的 3.12 亏损相当。

Loop-Residual 包含两个试验。首先,将具有 81M 参数的 Loop-Residual GPT-2 模型 (GPT2-81M) 与具有 124M 参数的 GPT-2 模型 (GPT2-124M) 进行对比。GPT2-124M 由 12 个 Transformer 层组成,而 Loop-Residual GPT2-81M 在 6 个 Transformer 层上使用 6 个循环。第二个试验将具有 45M 参数的 Loop-Residual GPT-2 模型 (GPT2-45M) 与相似大小的 Lite GPT-2 模型 (GPT2-45M-Lite) 进行对比。GPT2-45M-Lite 具有单个 Transformer 块层,用于单次预测,而 Loop-Residual 版本在单个 Transformer 块上循环两次。两个试验都使用了 OpenWebText 数字集,测量的训练历元时光为:GPT2-45M-Lite 150 毫秒,Loop-Residual GPT2-45M 177 毫秒,GPT2-81M 1,377 毫秒。

在第一个试验中,Loop-Residual GPT2-81M 模型在 OpenWebText 数字集上的验证亏损为 3.11,与 GPT2-124M 模型的 3.12 亏损相当。这一结果意义重大,因为与 GPT2-124M 模型相比,Loop-Residual 模型使用的参数降低了 35%,且唯一层数降低了一半。这表明,通过 loop-residual 机制进行迭代改善可以增强模型的逼近才能。在第二个试验中,Loop-Residual 模型的验证亏损为 3.67(之前为 3.98),训练亏损为 3.65(之前为 3.96)。通过在单个 Transformer 块上循环两次,该模型有效地模拟了更深的互联网,从而在不增长模型大小的情况下,相比单遍基线模型实现了显著的性能提升。

总而言之,研发人员提出了环路残差神经互联网 (Loop-Residual Neural Network),它通过迭代完善利用更长的推理时光,使较小的神经互联网模型能够在低端设备上取得更佳成果。与习俗的单遍模型相比,该方法能够更有效地捕捉困难的模式和依赖关系。试验表明,环路残差模型的性能优于同等规模的基线模型,并且与参数更少的大型模型的性能相当。将来的发展方向包括神经互联网架构的新可能性,尤其是在动力受限的设备上,需要进行更深入的计算推理的任务。

文章地址:https://arxiv.org/abs/2409.14199v1

本文来自作者投稿,著作权归原作者所有。如需转载,请注明出处:https://www.nxrte.com/jishu/57482.html